대형 언어 모델의 세계로 - ChatGPT의 원리와 활용에 대한

개요와 전체 목차 및 저자 소개는 아래의 이전 글에서 보실 수 있습니다.

대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 개요

안녕하세요 최근에 가장 많이 사용이 되고 있는 대형 언어 모델의 세계로 입문하고자 하시는 분들을 위해서 좋은 유튜브 강좌를 시리즈로 작성해 보려 합니다.원 저자는 Andrej Karpathy 로 스텐포

daeson.tistory.com

지난번에 데이터셋의 텍스트 시퀀스를 토크나이저를 사용해 토큰 시퀀스로 변환했어요.

결과를 보면, 예를 들어 Fine Web 데이터셋에서는 약 44테라바이트의 디스크 공간을 차지하는 데이터가 있으며,

이는 약 15조 개의 토큰 시퀀스로 구성되어 있어요.

여기에서 우리가 보는 것은 데이터셋의 첫 몇 천 개 토큰 정도지만, 전체적으로 15조 개가 존재한다는 점을 기억해야 해요.

또한, 중요한 점은 각 토큰은 단순히 숫자로 표현되는 고유한 ID일 뿐이며, 이 숫자 자체에 의미는 없다는 거예요.

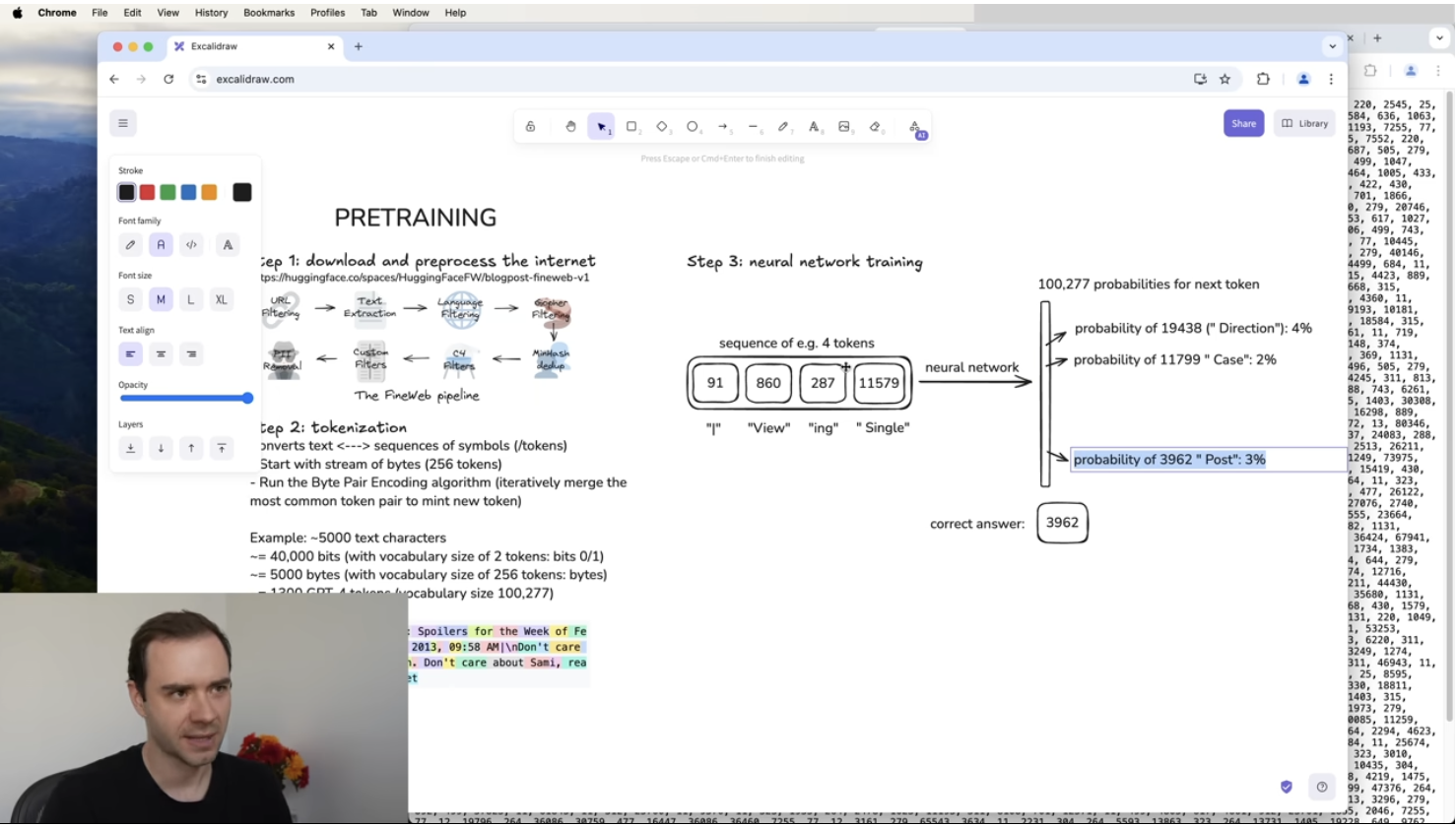

신경망 훈련 과정

이제 신경망을 훈련하는 단계에 들어갈게요.

이 과정에서는 토큰들이 어떻게 순차적으로 나타나는지에 대한 통계적 관계를 모델링하는 것이 핵심이에요.

- 토큰 윈도우 생성

- 데이터에서 랜덤하게 일정 길이의 토큰 윈도우(Token Window)를 선택해요.

- 윈도우 크기는 0개에서 최대 8,000개까지 다양할 수 있어요.

- 너무 긴 윈도우는 계산 비용이 많이 들기 때문에, 8,000개, 4,000개, 16,000개 같은 적당한 크기를 정해서 사용해요.

- 여기서는 예제용으로 4개의 토큰만 사용해볼게요.

- 다음 토큰 예측

- 예를 들어, 우리가 선택한 4개의 토큰이 **"bar", "view", "in", "space"**라고 해볼게요.

- 이 뒤에 올 다음 토큰이 무엇인지 예측하는 것이 신경망의 목표예요.

- 정답은 3962라는 토큰(ID)인데, 처음에는 신경망이 무작위로 예측하게 돼요.

- 신경망 입력과 출력

- 입력: 길이가 가변적인 토큰 시퀀스 (최대 8,000개).

- 출력: 다음에 올 토큰에 대한 확률 분포.

- 예를 들어, 신경망이 예측한 확률이 다음과 같다고 가정해볼게요:

- "space" = 4%

- "11799" = 2%

- "3962" = 3%

- 하지만 실제 정답이 3962이므로, 신경망은 이 확률을 높이도록 학습해야 해요.

정답이 되는 토큰이 출력될 확률을 높아가도록 학습을 해요.

신경망 업데이트 과정

이제 신경망을 학습시키는 방법을 설명할게요.

- 우리가 샘플링한 윈도우에서 실제 정답(3962)이 존재한다는 걸 알고 있어요.

- 신경망이 처음에는 랜덤한 확률을 주지만, 목표는 올바른 토큰의 확률을 높이고, 틀린 토큰의 확률을 낮추는 것이에요.

- 이를 위해 수학적 최적화 방법(예: 경사 하강법)을 사용해 가중치를 조정해요.

- 한 번 업데이트가 이루어지면, 같은 입력이 들어왔을 때:

- "3962"의 확률이 3% → 4%

- 다른 오답들은 확률이 낮아짐

이러한 과정이 데이터셋의 모든 토큰에서 동시에 수행되며, 신경망은 점점 더 정확한 확률을 예측하는 방향으로 조정돼요.

신경망 훈련의 핵심

- 신경망은 입력된 토큰 시퀀스를 보고, 다음 토큰의 확률을 예측하는 방식으로 훈련돼요.

- 처음에는 무작위 확률로 시작하지만, 정답에 가까운 확률을 높이는 방향으로 조정돼요.

- 이 과정이 수많은 배치(batch) 단위로 병렬로 실행되면서, 신경망이 데이터셋의 패턴을 학습하게 되는 거예요.

이제 신경망 내부 구조를 좀 더 자세히 살펴볼게요!

'생성형 AI' 카테고리의 다른 글

| 대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 (6) 추론 (0) | 2025.02.18 |

|---|---|

| 대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 (5)신경망 내부 (1) | 2025.02.17 |

| 대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 (3)토큰화 (0) | 2025.02.12 |

| 대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 (2)학습데이터 (2) | 2025.02.11 |

| 대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 (1)소개 (0) | 2025.02.10 |

댓글