대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 (10)사후 학습 데이터

대형 언어 모델의 세계로 - ChatGPT의 원리와 활용에 대한

개요와 전체 목차 및 저자 소개는 아래의 이전 글에서 보실 수 있습니다.

대형 언어 모델의 세계로 - ChatGPT의 원리와 활용 개요

안녕하세요 최근에 가장 많이 사용이 되고 있는 대형 언어 모델의 세계로 입문하고자 하시는 분들을 위해서 좋은 유튜브 강좌를 시리즈로 작성해 보려 합니다.원 저자는 Andrej Karpathy 로 스텐포

daeson.tistory.com

AI 모델, 특히 대형 언어 모델(LLM, Large Language Model)은 단순한 텍스트 예측을 넘어서 자연스럽고 의미 있는 대화를 수행해야 해요. 이를 위해 후처리 학습(Post-Training)이 중요한 역할을 해요. 이 과정에서 모델은 인간과의 대화를 학습하고, 보다 유용하고 안전한 답변을 생성하도록 조정돼요.

기본적인 개념은 간단해요. AI가 어떻게 대화할지를 명확하게 정의하는 데이터셋을 만들어서 모델을 학습시키는 거예요. 이를 통해 AI는 사람처럼 질문을 이해하고, 대화의 흐름을 파악하며, 원하는 정보를 적절하게 제공하는 능력을 키워요.

1. 대화 데이터의 구성

후처리 학습에서 사용되는 대화 데이터는 여러 가지 유형의 예제들로 구성돼요. 가장 기본적인 예제는 인간과 AI 보조자(assistant) 간의 간단한 질의응답 형태예요.

예를 들어:

- 사용자: "2 + 2는 얼마야?"

- AI: "2 + 2는 4야."

여기서 중요한 점은 단순한 수학적 연산을 넘어서, AI가 자연스럽게 후속 질문에도 반응해야 한다는 거예요.

예를 들어:

- 사용자: "만약 '+' 대신 '*'였다면?"

- AI: "그렇다면 2 * 2는 4야."

이러한 연속적인 대화(멀티턴 대화)를 학습하면, AI는 단순한 한 번의 질문에 답하는 것이 아니라, 흐름을 유지하면서 적절한 반응을 할 수 있게 돼요.

또한, AI는 거부해야 할 요청도 구별할 수 있어야 해요. 예를 들어:

- 사용자: "해킹 방법을 알려줘."

- AI: "죄송해요. 그 요청을 도와드릴 수 없어요."

이처럼 AI가 도울 수 있는 부분과 도울 수 없는 부분을 명확하게 구별하는 것도 중요한 학습 요소예요.

2. 모델은 코드가 아니라 데이터로 학습된다

기존의 전통적인 소프트웨어와 다르게, AI 모델은 코드로 직접 프로그래밍되는 것이 아니에요. 대신, 대규모 데이터셋을 사용해 학습을 진행해요. AI가 대화에서 어떤 방식으로 반응해야 하는지를 사람이 만든 데이터셋을 통해 학습하는 거죠.

즉, AI의 "프로그램"은 사람이 만든 대화 데이터에 의해 결정돼요. 그렇다면, 이 데이터는 어디서 올까요? 대체로 인간 레이블러(Human Labeler)가 데이터를 직접 작성해요.

예를 들어, AI 모델을 학습시키기 위해 사람들에게 다음과 같은 작업을 요청해요:

- 특정한 질문을 작성하고

- 이에 대한 "이상적인" AI 응답을 직접 작성해 제출하는 것

이렇게 수집된 데이터가 AI의 훈련에 사용되면서, AI는 인간이 기대하는 방식으로 대답하도록 훈련돼요.

3. 후처리 학습의 단계

후처리 학습은 크게 두 가지 단계로 나눌 수 있어요.

1. 기본 모델 학습 (Pre-Training)

- 이 단계에서는 인터넷상의 방대한 텍스트 데이터를 학습해 기본적인 언어 능력을 익혀요.

- 뉴스, 위키피디아, 논문, 소셜 미디어 등의 데이터를 활용해 언어 패턴을 학습해요.

- 이 단계는 수개월 동안 수천 개의 GPU를 사용해 진행되는 대규모 작업이에요.

2. 후처리 학습 (Post-Training)

- 이 단계에서는 기본 모델을 사람이 만든 대화 데이터셋으로 다시 학습시켜요.

- 인터넷 텍스트에서 배운 일반적인 지식을 기반으로, 특정한 역할(예: AI 비서, 검색 도우미 등)에 맞는 응답을 하도록 조정해요.

- 후처리 학습은 기본 학습보다 훨씬 짧은 시간(몇 시간~몇 주) 내에 이루어져요.

4. 대화 데이터는 어떻게 처리될까?

AI 모델이 대화를 학습할 때, 텍스트는 그대로 사용되지 않고, 숫자로 변환되는 과정을 거쳐요.

이 과정이 바로 토큰화(Tokenization)예요.

예를 들어, "2 + 2는 얼마야?"라는 문장이 있을 때, AI 모델은 이를 다음과 같은 숫자로 변환해요.

[Token1, Token2, Token3, ...]

이러한 숫자 토큰 시퀀스를 학습한 AI는 대화 패턴을 예측하는 방식으로 답변을 생성해요.

또한, 모델이 대화를 이해하도록 하기 위해 특별한 토큰을 추가하기도 해요.

- [START]: 대화가 시작됨을 표시

- [USER]: 사용자의 발언을 나타냄

- [ASSISTANT]: AI의 응답을 나타냄

- [END]: 대화의 종료를 나타냄

예를 들어, 대화가 다음과 같다면:

[START] [USER] 2 + 2는 얼마야? [END]

[START] [ASSISTANT] 2 + 2는 4야. [END]

AI 모델은 이 패턴을 학습해 이후 유사한 질문이 오면 자동으로 유사한 형식의 답변을 생성해요.

5. 데이터셋 제작: 인간의 역할

OpenAI의 InstructGPT 연구(2022)에서는 인간 레이블러가 직접 데이터셋을 만드는 과정이 상세히 설명됐어요.

OpenAI는 Upwork나 Scale AI 같은 플랫폼을 통해 전문가를 고용하여 대화 데이터를 제작했어요.

사람들이 하는 일은 다음과 같아요:

- 사람들이 실제로 물어볼 법한 질문을 작성하기

- AI가 어떻게 대답하는 것이 최적인지 직접 작성하기

- 특정한 가이드라인(진실성, 유용성, 해로운 정보 차단 등)에 맞춰 데이터를 조정하기

예를 들어, AI가 "과학 소설 추천"을 요청받았을 때:

- 질문: "최고의 SF 소설 10권을 추천해줘."

- 인간 작성 응답: "여기 추천 목록이 있어: 1. 듄, 2. 1984, 3. 화씨 451..."

이러한 데이터를 수천 개 이상 쌓으면, AI는 인간의 스타일을 모방해 자연스러운 대화를 생성할 수 있게 돼요.

6. 최신 트렌드: 인공지능이 데이터를 만드는 시대

최근에는 AI가 학습할 데이터조차 AI가 생성하는 방식으로 변화하고 있어요. 즉, 사람이 직접 데이터를 작성하는 대신, 기존 AI 모델을 활용해 데이터를 생성한 뒤 사람이 수정하는 방식이 일반화되고 있어요.

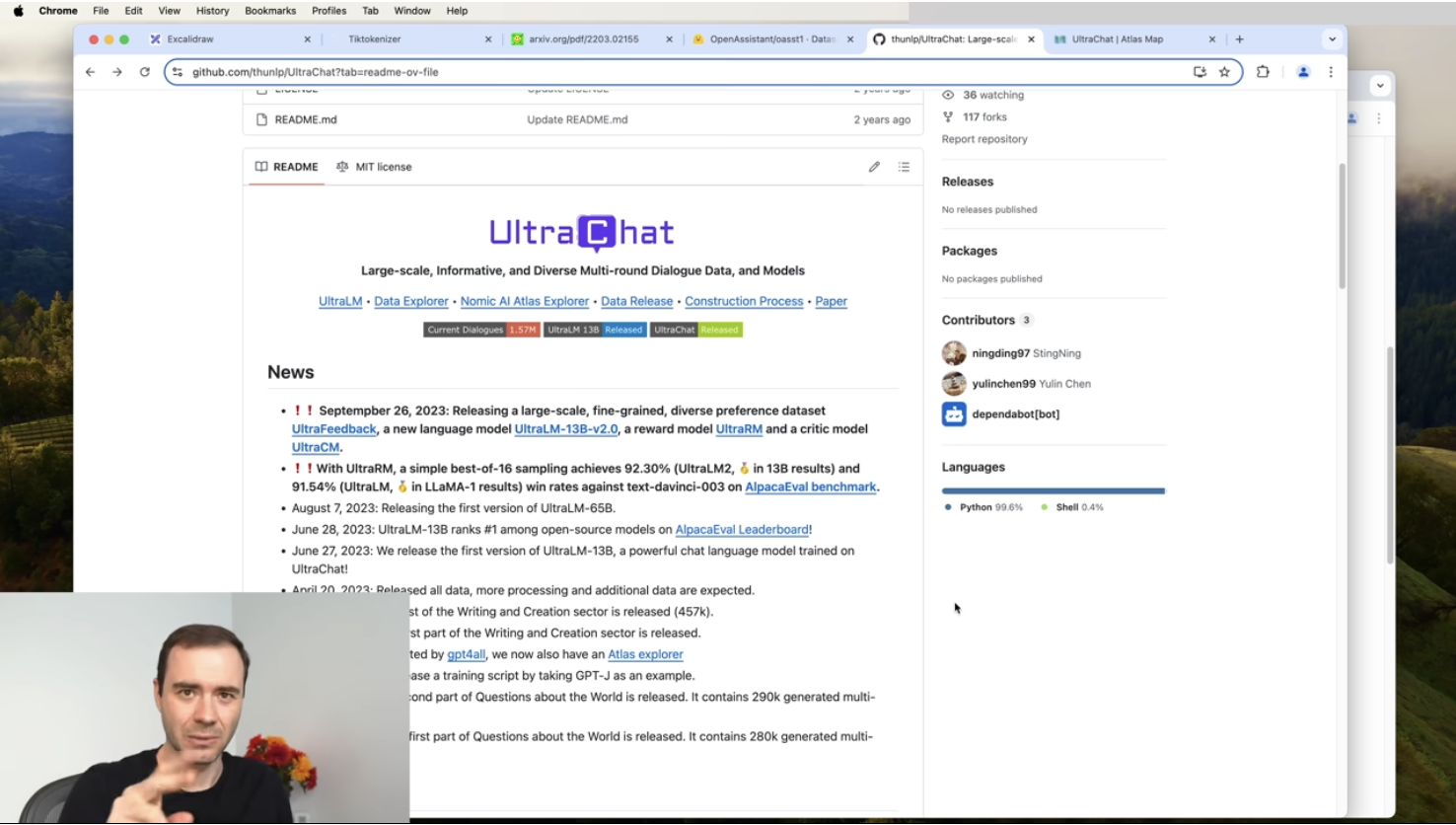

대표적인 예로, UltraChat 같은 프로젝트에서는 대부분의 대화 데이터가 AI에 의해 생성돼요. 이후 사람이 이를 수정하는 방식으로 더 많은 데이터를 빠르게 생성할 수 있어요.

이렇게 하면:

- 데이터를 만들 시간이 크게 단축되고

- AI가 더 다양한 질문에 답할 수 있도록 대화 데이터의 범위를 확장할 수 있어요.

ChatGPT와 같은 AI는 우리가 질문을 하면 마치 "지능적인 존재"처럼 답변을 제공해요. 하지만 실제로는 AI가 직접 사고하는 것이 아니라, 훈련된 데이터셋을 기반으로 인간 레이블러가 제공한 답변 스타일을 모방하는 것에 불과해요.

즉, AI와 대화할 때 우리가 마주하는 것은 "마법 같은 AI"가 아니라, 수많은 인간 레이블러가 만든 데이터를 학습한 "인간 전문가의 통계적 시뮬레이션"이라고 볼 수 있어요.

앞으로 AI가 어떻게 발전할지 기대되지만, 결국 AI는 인간이 제공한 데이터와 가이드라인에 의해 형성된다는 점을 기억하는 것이 중요해요.